|

大动作不停,Google加入开源战局!低配版“Gemini ”Gemma来了!相当于OpenAI把GPT-3开源了

2月21日,在与闭源的OpenAI打得火热的同时,Google突然加入了开源的战局。北京时间夜间Google突然宣布,开源了一个新的模型系列Gemma,这个模型使用了与它最强的Gemini同源的技术,并且在一系列的标准测试上秒杀了几款今天最热门的开源模型。

怎么理解这个动作的重要性呢?你可以粗暴的理解为:

这有点像现在正在训练更强大的GPT-5的OpenAI,把GPT3的低参数版给开源了。(前几天Sam Altman被问过这个问题,你们是否会在未来把GPT3开源,他没有直接回答。现在看来Google针对性很强啊。)

(X上一张有意思的图)

根据Google官方对Gemma的介绍,它的基本信息如下:

Gemma是谷歌开源的一个大型语言模型,而非像Gemini那样是多模态的,它基于与Gemini相同的技术构建,但完全公开并允许商用授权。

Gemma模型有两个主要版本,分别是Gemma 7B(70亿参数)和Gemma 2B(20亿参数)。这些模型在大规模的数据集上进行了训练,数据集包含了以英语为主的网络文档、数学数据以及代码数据,总量达到了6万亿tokens。

Gemma模型的特点包括:

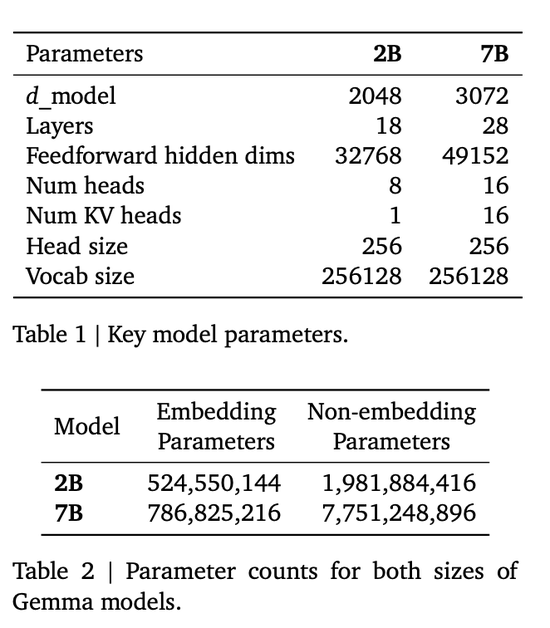

架构细节:Gemma模型具有不同的参数规模,Gemma-2B有18层,d_model为2048,而Gemma-7B有28层,d_model为3072。这些模型还具有不同的前馈隐藏维度、头数和KV头数,以及词汇量。

新技术:Gemma采用了一些新技术,如Multi-Query Attention、RoPE Embeddings、GeGLU激活函数以及Normalizer Location,这些技术有助于提高模型的性能。

评测结果:谷歌官方宣称Gemma模型在70亿参数规模的语言模型中表现最佳,甚至超过了一些参数量更大的模型。

开源情况:Gemma模型遵循一个自定义的开源协议,允许商业使用。

发布完,Jeff Dean就对这个系列模型划了重点:

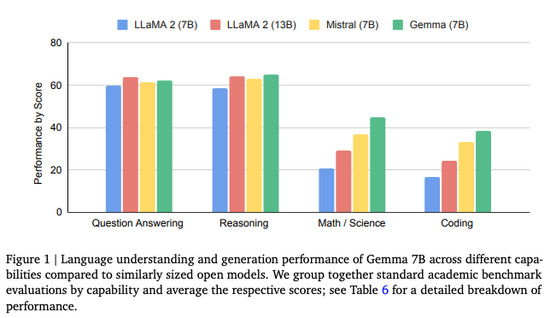

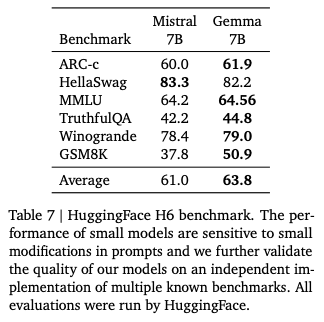

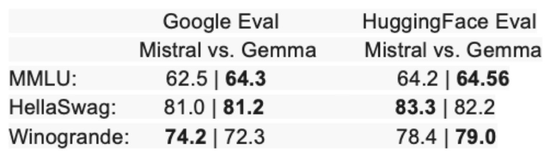

Gemma-7B模型在涵盖通用语言理解、推理、数学和编程的8项基准测试中,性能超过了广泛使用的Llama-2 7B和13B模型。它在数学/科学和编程相关任务上,通常也超过了Mistral 7B模型的性能。

Gemma-2B IT和Gemma-7B IT这两个经过指令调整的模型版本,在基于人类偏好的安全评估中,都优于Mistral-7B v0.2指令模型。特别是Gemma-7B IT模型在遵循指令方面也表现更佳。

(有意思的是,在Google晒出的成绩对比中,阿里的千问背后的模型Qwen系列表现也很亮眼)

我们也发布了一个负责任的生成性人工智能工具包(Responsible Generative AI Toolkit),它为负责任地使用像Gemma模型这样的开放模型提供了资源,包括:

关于设定安全政策、安全调整、安全分类器和模型评估的指导。

学习可解释性工具(Learning Interpretability Tool,简称LIT),用于调查Gemma的行为并解决潜在问题。

一种构建具有最小样本量的强大安全分类器的方法论。

我们发布了两个版本的模型权重:Gemma 2B和Gemma 7B。每个版本都提供了预训练和指令调整的变体。

我们为所有主要框架提供了推理和监督式微调(SFT)的工具链:通过原生Keras 3.0支持的JAX、PyTorch和TensorFlow。

提供了即用型的Colab和Kaggle笔记本,以及与流行的工具如Hugging Face、MaxText、NVIDIA NeMo和TensorRT-LLM的集成,使得开始使用Gemma变得简单。

预训练和指令调整的Gemma模型可以在您的笔记本电脑、工作站或Google Cloud上运行,并且可以轻松部署在Vertex AI和Google Kubernetes Engine(GKE)上。

在多个AI硬件平台上的优化确保了行业领先的性能,包括NVIDIA GPU和Google Cloud TPUs。

使用条款允许所有规模的组织负责任地进行商业使用和分发。

可以看到Jeff Dean和Google这次都十分强调开源模型的安全性和具体的实打实的配套设施和举措。这似乎也直至被诟病Close AI且被外界质疑安全性保障的OpenAI。

现在,憋坏了的Google正式四面开战了。未来它将用Gemma对抗Llama,用Gemini对抗GPT。

无论是开源还是闭源,竞争越来越焦灼了。

|